在贝壳找房这样一家业务覆盖全国、数据规模庞大且结构复杂的居住服务科技平台,高效、可靠的数据处理是业务决策、产品智能化和精细化运营的基石。贝壳的数据治理中台,特别是其核心的数据处理服务,经过多年的迭代与实践,已形成一套体系化的解决方案,旨在解决数据孤岛、质量不一、处理效率低下等经典难题,为全公司提供统一、可信、敏捷的数据服务。

一、数据处理服务的核心定位与挑战

贝壳的数据处理服务作为数据中台的核心引擎,其核心定位是:对来自各业务线(新房、二手房、租赁、装修、金融等)的异构、海量原始数据进行采集、清洗、加工、整合与建模,最终产出标准化、资产化的数据产品,服务于数据分析、用户画像、智能推荐、风控决策等多种业务场景。

面临的挑战是多维度的:

- 数据源异构且动态变化:数百个业务系统、日志、第三方数据,格式不一,且业务变更频繁。

- 规模与性能要求高:日处理数据量达PB级,需保证T+1甚至实时数据产出的时效性。

- 质量与一致性是生命线:房源、客源、交易等核心数据的准确性直接关系到业务可信度。

- 敏捷响应业务需求:业务探索和创新速度快,数据处理流程需要灵活可配置,支持快速迭代。

二、数据处理服务的架构与实践

贝壳数据处理服务构建了一个分层、解耦的体系,主要包含以下关键层次:

1. 统一接入与缓冲层

- 建立了统一的数据接入平台,支持DB日志解析、消息队列(如Kafka)、API拉取、文件传输等多种接入方式。

- 所有原始数据首先进入数据湖(基于HDFS/Object Storage),实现原始数据的永久存储与回溯,为批流一体处理奠定基础。

2. 核心计算与调度引擎层

- 批处理:以成熟的Hadoop/Spark生态为核心,处理T+1的ETL任务。通过自研的可视化任务开发平台,将复杂的SQL和代码任务配置化、模板化,降低了开发门槛。

- 流处理:引入Flink构建实时计算能力,用于实时指标计算、事件监听与实时特征生成,满足风控、实时推荐等场景。

- 统一调度系统:自研的调度中心负责管理数以万计的数据处理任务,具备强大的依赖解析、优先级调度、失败重试与智能报警能力,保障了任务链的稳定运行。

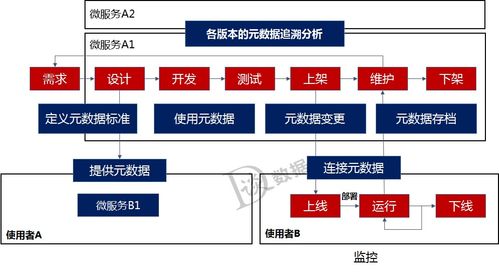

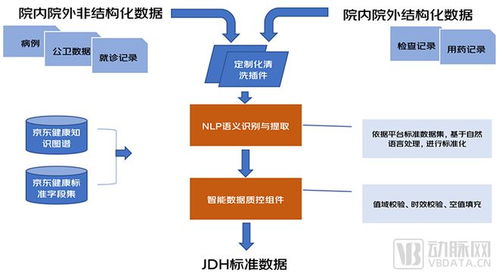

3. 数据质量与血缘治理层(核心保障)

- 质量监控体系:在关键的数据处理节点(如ODS->DWD->DWS)植入质量检查规则。规则包括:非空校验、唯一性校验、值域校验、一致性校验、波动率监控等。一旦触发阈值,系统自动告警并阻断下游任务,防止“脏数据”扩散。

- 全链路数据血缘:自动采集并可视化从数据接入到最终数据产品(报表、API)的全链路血缘关系。这极大地提升了问题排查效率(快速定位影响范围)、变更影响评估和数据资产的可理解性。

4. 数据资产与服务化层

- 经过标准化处理的数据,按照维度建模等理论,分层存储于数据仓库(DWD明细层、DWS汇总层、DIM维度层、ADS应用层)。

- 通过统一数据服务(UDAS),将数据表、指标、模型以API、数据文件、消息等多种形式发布出去,供业务系统、BI工具、算法平台调用,实现了数据资产的可复用与闭环。

三、关键实践与成效

1. 标准化与模型驱动

定义了全公司统一的业务实体标准(如“房源”、“客源”、“经纪人”)和指标体系。所有数据处理均围绕这些标准模型展开,确保了数据在跨业务线使用时口径一致、可比。

2. 平台化与自助化

将常用的数据处理逻辑(如去重、拉链、SCD2处理等)沉淀为平台组件。业务和数据分析师可以通过可视化界面,以“搭积木”的方式完成数据清洗和轻度汇总,大幅提升了效率,释放了数据工程师的生产力。

3. 成本与效能优化

通过计算存储分离、冷热数据分层、作业运行时优化(如Spark参数调优)、小文件合并等技术手段,在数据量持续增长的情况下,有效控制了计算和存储成本的增速。

4. 成效显著

- 数据产出时效性:核心T+1报表交付时间从过去的数小时缩短至稳定在1小时内。

- 数据质量:关键业务数据的质量检核通过率提升至99.9%以上,数据问题引发的业务投诉大幅下降。

- 开发效率:通过平台化,简单数据需求的交付周期从天级缩短至小时级。

- 业务价值:为“楼盘字典”(贝壳核心的真实房源数据库)、ACN合作网络效率分析、经纪人信用分、VR看房智能导览等核心业务提供了坚实、可信的数据支撑。

四、未来展望

贝壳的数据处理服务仍在持续进化,未来的重点将集中在:

- 智能化:引入AI进行任务智能调优、异常自动检测与根因分析、数据质量问题的自动修复。

- 实时化深化:拓展实时数据处理场景,构建更完善的实时数据仓库,满足更敏捷的业务决策。

- 云原生与一体化:向云原生架构演进,实现更极致的弹性与资源利用率;进一步融合批流,实现真正意义上的一体化数据处理体验。

贝壳数据处理服务的实践表明,构建一个强大的数据治理中台,技术架构是骨架,而标准化、平台化、质量内建和全链路可观测才是其灵魂。它不仅是技术的整合,更是将数据治理理念深度融入每一个数据处理环节,从而将原始数据有序地转化为驱动业务增长的强大资产。